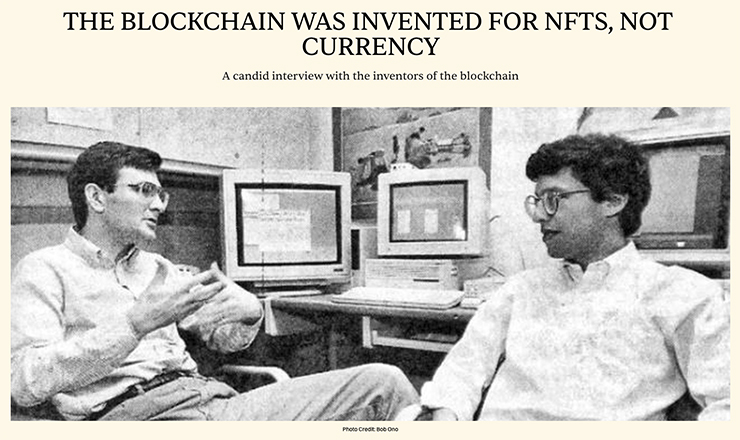

80年代後半から90年代初頭にかけてブロックチェーンの基礎を発明したスコット・ストーネッタとスチュアート・ハーバーのインタビュー記事です。

暗号通貨のためではなく、そもそものブロックチェーンがどのような概念なのかを紹介してくれています。

「デジタル指紋」「ハッシュ」「序数」など難しいワードが多くて正しい理解は難しそうですが、できるだけわかりやすく説明してくれています。

ブロックチェーンがもたらす未来について、本質的で中道的で有用的なビジョンに思えます。

そして、サトシ・ナカモトの功績が素晴らしいこともわかります。

「デジタル署名と暗号ハッシュ関数は1989年秋までに提案、実装され、広く理解されていました。これらのツールは、特定のドメイン内の記録の整合性を保証するために、単一の信頼できる主体(人物、ソフトウェア、ハードウェアなど)を必要とするという、比較的単純な解決策を示唆していました。」

「スコットと私は電子マネーを発明しようとしていたわけではありません。実際、暗号コミュニティでは1980年代に遡り、純粋にデジタルなマネーを作るための取り組みが既に進められていました。私たちの焦点はより広範で、電子記録を含むあらゆる記録の完全性について真摯に懸念していました。」

「本質的には、暗号通貨よりもNFTのコンセプトに共感していたんですよね?NFTを芸術作品、証書、特許、そして様々な申請を検証する手段として考えると、当初の目的と一致しているように思えます。」

「特にビットコインの文脈においては、権力の集中が存在することは認めますが、その根底にある前提は変わりません。『誰にとっても信頼できる文書とは、すべての参加者が共同で信頼責任を共有する文書である』というものです。この概念は非常に価値があり、同様の精神を持つ多くの機関の基盤となり得ると信じています。 」

「ブロックチェーンは、信頼性を確保するための分散化への欲求と、中央集権化による業務効率化の必要性との間に、健全な緊張関係をもたらします。この緊張関係は、よりバランスと多様性をもたらすため、極端な中央集権化よりも好ましいものです。」

「さらに強調したいのは、様々なブロックチェーンネットワークが共存し、オンチェーン/オフチェーン機能といった要素に基づいて差別化できる未来を思い描いているということです。こうした機能の多様性は、活気あるエコシステムの前向きな兆候です。スチュアートと私は、ささやかな方法で、これらのブロックチェーンネットワーク間の相互運用性を促進し、コミュニティ意識を育むことを目指しています。」

詳しくは下記をどうぞ。

印刷メディアの現状と未来についての、熱く、濃く、読み応えある記事です。

「印刷は死んだ」という絶望的なミームに対して、光明をもたらす回答のように感じます。

以下は、ほんの一部の抜粋と意訳です。

「つまり(印刷物の)物理的な制作過程は、私たちがデジタルへと溶け込むにつれて、ますます一般的ではなくなりつつある知識体系である。」

「材料は高騰し、市場は縮小し、伝統的な印刷業界の専門知識は失われつつある。そのため、小規模出版社として立ち上げるのは、客観的に見てかつてないほど困難になっているかもしれない。印刷物の現在の魅力と独自性は、アーティストやスタジオが印刷という名のもとで、経済的に持続可能な事業を必死に育てようとしている状況とは対照的だ。こうして、印刷物は全般的に「死んだ」というあまりにもありふれた宣言が広まっている。」

「私たちはやり遂げたと確信しています。アーティストも私たちの成功を知っています。機械のグリースがまだ爪の裏に残っています。素晴らしい仕事をしたと確信しながら、夜は安心して眠りにつくことができます。」

「撮影監督は、カメラアングル、動き、静止、フレーミング、そしてミザンセーヌを操ります。それは、私たちが紙、製本構造、インクの不透明度、そして物質性を操るのと同じです。」

「本をデザインしてから、後から制作方法を考えるようなことは決してしたくありません。制作は、本のデザインとコンセプトの最初から織り込まれているのです。InDesignでレイアウトをあれこれ試しながら紙を選び、書体の方向性を決めると同時に、本の製本構造も決めているのです。」

「製版から機械の操作まで、そのプロセス全体が多くの人にとって全くの謎であり、もはや深く掘り下げて研究する意欲を失っている」

「ブックフェアでは、人々が印刷物に持ち込む様々なアイデアやアプローチを目にすることができます。私たちの経験の多くがデジタル化されている現代において、物理的な印刷物には異なる種類の価値があります。それは、単なる情報伝達ではなく、繋がり、技術、そして実体感といった価値なのです。」

「本、印刷物、DIY出版への渇望は高まっていますが、同時に、印刷業者、出版社、アーティストにとって、経済的に持続可能な印刷事業を育てることはますます困難になっています」

「私たちの経験の多くがデジタル化された世界では、物理的な印刷物は異なる種類の価値を持ちます。それは、純粋な情報伝達というよりも、つながり、職人技、そして実体性に関する価値です。」

「アクセスしやすくするためには、ものをアクセスしやすくする必要があり、そのように価格設定を真剣に考えなければならないことを、人々や企業は本当に理解する必要があると思います。25部限定で3万ポンドのエディションをリリースするだけでは、アクセスしにくくなります。誤解しないでください。それらは素晴らしいものですが、人々がそれを買わなければ、業界は衰退します。」

「印刷物は日常的なものではなく、はるかに特別なものへと変化しました。これが印刷物の入手しやすさに不安をもたらすのか、それとも将来的な影響に安心感を与えるのか、まだ分かりません。この変化は、小規模出版社の運営を今日の状況に理想的なものにしています。大量生産と競争するのではなく、小規模出版社は、それぞれの作品に深い思慮と配慮、そして価値を込めた限定版に注力できるのです。」

「この視点から見ると、印刷は衰退しているのではなく、ただひたすら待ち構えているだけだと思います。」

「インターネットによって印刷物は死ぬ」という話は30年以上前から聞いてきました。

そして今、印刷物の課題はクオリティではなくコストになったようです。

この課題はビジネスとして致命的になりかねない課題で、印刷に従事する人たちはこの解決策を持ち合わせていないように思われます。

「Video Killed The Radio Star」を聴きたくなりました。

I'm talking at a conference later this year (on UX+AI).

I just saw an ad for the conference with my photo and was like, wait, that doesn't look right.

Is my bra showing in my profile pic and I've never noticed…? That's weird.

I open my original photo.

No bra showing.I put… pic.twitter.com/CpoIgiXtUI

— Elizabeth Laraki (@elizlaraki) October 15, 2024

エリザベス・ララキはUI/UX分野の第一人者で、次回登壇するカンファレンスの主催者に経歴や顔写真などを提出しました。

プロモーションツールの制作過程で、レイアウトを変更して写真素材の矩形を変更するためにAIツールを使ったところ、シャツのポケットを消去して、胸元にブラが見えるような補正がされてしまったようです。

このエピソードを通じて、ララキさんがAIツールについて抱くようになった警戒感についての記事です。

UI/UXのエキスパートらしい考え方のような気がしました。

「AIは、女性のシャツはさらにボタンを外し、ボタンの周りに張りを持たせ、下にあるものを少し見せるべきだと考えたのです。」

「この奇妙なエピソードにもかかわらず、ララキはAIツールの普及に興奮していることを認め、ソーシャルメディア・マネージャーがこの手間のかかる作業にAIを使った理由を完全に理解している。」

「個人的には、AIにまつわる私の最大の不安、つまり、AIがどのように機能するのかが本当にわかっていないことを再認識させられた。何が入力されるかはわかっている。何が出てくるかはわかっている。その間に何が起こるのかは謎だ。」

「しかし、この経験は、なぜトレーニングデータが重要なのか、なぜツールの設計が重要なのか、そして最も重要なのは、なぜこれらのツールをどのように使うのかが重要なのかということに、私の目を開かせた。」

「ここで重要なのは警戒心だ。ララキがAIの 「破滅的外挿」と呼ぶような、SF的ストーリーの悪夢のようなシナリオに気を取られがちだ(念のため言っておくが、万が一そのような事態が起こったとしても、私は新しいロボットの支配者を歓迎する)。この話が力強いたとえ話になっているのは、一見無邪気だからだろう。カンファレンスの広告用のヘッド写真にちょっと手を加えただけ。ソーシャルメディア・マネージャーが賢いツールを使って時間を節約した。しかし、小さなことが重要なのだ。それらは、例えばロボットの侵略よりも簡単にレーダーの下をすり抜ける。奇妙な異常値が受け入れられるようになる。私たちの合理的と思われる感覚は変化する。」

AIツールは21世紀を方向づける素晴らしい大発明だと思っていますが、警戒するポイントが少し違っているような気がしています。

たかがプロモーションツールでも、そこでデザイナーが扱っているのは実在する個人の情報です。

AIに個人の情報を投げ込むことには、もっと倫理観があるべきと思っています。

スマホやPCの画面に向かっている時に無意識のうちに、自分がオーダーする側でスマホやPCを通して何かを受け取る気になっているなら、あなたが利用しているのはツール(道具)ではなくサービスです。

サービスを利用している時、そのサービスのレスポンスが速ければ速いほど、利用者は便利に感じて万能感を得て、そのサービスをリピートするようになるでしょう。

この万能感が利用者の倫理観を希薄にしているのかもしれません。UI/UXはこの万能感の演出をしているかもしれません。

また、プロモーションツールを制作するデザイナーも実在する個人です。

短い日程で変更に次ぐ変更が重なれば、倫理観を薄くして便利なAIツールを利用したくなるでしょう。

ここで警戒すべきは、SF的ストーリーの悪夢のようなAIツールではなく、そのような日程と変更になってしまった現実の要因でしょう。

難しくてよくわからない部分が多いです。

でも、いくつか賛同できそうな点がある気がしています。

「ワールドチェーンは人間のために設計された新しいブロックチェーンです。」

「このプロトコルは、カジュアルユーザーのガス代が最終的にボットやパワーユーザーからの手数料で賄われるような均衡を目指す。その間、ワールドコイン財団がスポンサーとなる。」

「無許可でオープンソースであり、最終的にはコミュニティによって独立して管理されることを意図しています。」

「重要なことは、Worldcoin-World IDのユニークなデジタルID-は、ますます高度化する人工知能が存在するオンライン世界において、人間らしさを示す重要な役割を果たすことができるということです。」

「World IDとWLDは、World Chain以外のネットワークでも使用・展開できる中立的な公共財であり続けるということだ。」

AI後の世界では、人であることが重要になるようです。

人と世界の関わり方を変わっていくような「公共財」になり得るとしたら、素晴らしいことのような気がします。

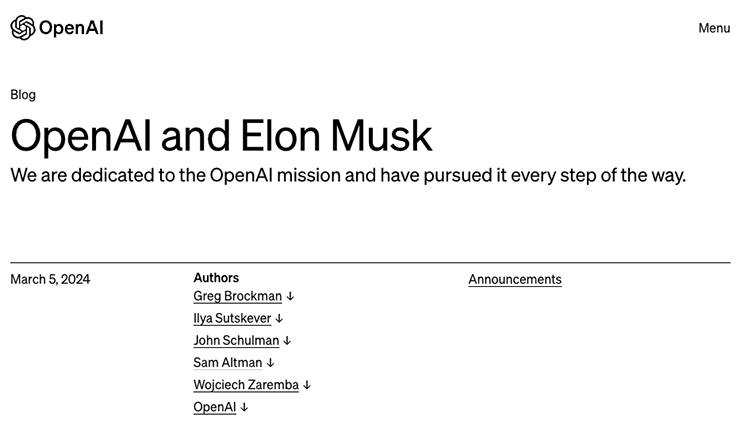

メールのやり取りも公開していて、全面的に争う姿勢のようです。

「袂を分かつ」という感じです。

OpenAIの理想と葛藤がうかがえる気がします。

AGI の構築には膨大なリソースが必要で、それを賄える可能性があるのはGoogleだけのようです。

スケールでGoogleに対抗するのは絶望的なようです。

「実行とリソースに劇的な変化がなければ、OpenAI が DeepMind/Google に関連する可能性は 0% であると私は判断しています。・・・数億集めても足りない。これにはすぐに年間数十億ドルが必要です。」

「openAI のオープンとは、AI が構築された後は誰もが AI の成果から恩恵を受ける必要があることを意味しますが、科学を共有しなくてもまったく問題ありません…」と言うと、イーロンは「そうです」と答えました。」

「今日の OpenAI は現金を浪費しており、その資金調達モデルは Google (800 億企業) と真剣に競争できる規模に到達できないように思えます。真剣に競争できないのに公開で研究を続けている場合、実際には状況を悪化させて「無料」で彼らを支援している可能性があります。なぜなら、進歩したものはコピーしてすぐに大規模に組み込むのが非常に簡単だからです。」

「製品をゼロから構築することは AI 研究の焦点を奪い、長い時間がかかり、企業が Google の規模に「追いつく」ことができるかどうかは不透明であり、投資家は間違った方向に過度の圧力をかける可能性があります。私が思いつく最も有望な選択肢は、先ほども述べたように、OpenAI がドル箱として Tesla に所属することです。」

「私たちは、個人が OpenAI を完全に制御することは使命に反すると感じたため、Elon と営利契約の条件に同意することができませんでした。」

「Elon 氏は、Google/DeepMind に関連する競合他社が必要であり、自分でそれを行うつもりであると述べ、OpenAI を去りました。彼は、私たちが自分たちの道を見つけるのを応援すると言いました。」

AIが誰かのコントロール下にあることを拒むOpenAIの姿勢は素晴らしいと思います。

『誰もが AI の成果から恩恵を受ける』のも重要なことだと思います。

でも、ツールとしてのAIがブラックボックスになることはディストピアな気もします。

上記の動画を生成したプロンプトだそうです。

A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

これまでAIで生成された動画に特有の「奇妙さ」「グロテスクさ」が少なくなってます。背景の群衆が個別に違和感なく歩いてるのがすごいです。

Soraのオフィシャルサイトには下記のように書かれています。詳しく解りませんが説得力があります。

「Soraは、複数のキャラクター、特定の種類の動き、被写体や背景の正確な詳細を持つ複雑なシーンを生成することができます。このモデルは、ユーザーがプロンプトで求めたものだけでなく、それらが物理的な世界にどのように存在するかも理解します。これまでのモデルには弱点があります。複雑なシーンの物理を正確にシミュレートすることに苦労し、原因と結果の具体的な例を理解できない可能性があります。例えば、人はクッキーを齧るかもしれないが、その後、クッキーには齧った跡がないかもしれない。」

Soraのオフィシャルサイトには「安全性」というセクションもあります。

「私たちは、世界中の政策立案者、教育者、アーティストを巻き込み、彼らの懸念を理解し、この新しいテクノロジーのポジティブな使用例を特定します。広範な調査とテストにもかかわらず、私たちは人々が私たちのテクノロジーをどのように使用するか、またどのように悪用されるかをすべて予測することはできません。だからこそ私たちは、実際の使用例から学ぶことが、時間をかけてより安全なAIシステムを作り、リリースしていく上で重要な要素であると考えています。」

新規性や自分たちの技術のアピールではなく、この段階で安全性を前面に出すことは企業の姿勢として公正さと信頼感があると思います。

こういった姿勢を取れないテクノロジーは淘汰されることになるかも。

日本の企業ではとても追いつけないくらい先を進んでいる気がします。

サービスとしてローンチされたのではなく、技術紹介として発表したものです。

テキストからAIで生成された動画はこれまでもありましたが、より一貫性のある動画を生成できるようです。

元動画を変換するのは楽しいツールになるかもしれませんが、テキストから生成される動画は著作権の問題もあって、仕事では使いどころがなさそうな気がします。

技術に詳しい人なら、また違う可能性を見つけるのかも。

「LUMIERE」ってネーミングは気に入りました。

Lumiere >>

https://lumiere-video.github.io/

興味深い記事です。

AIのアウトプットを人が作った作品として提示するのは、パロディだとしてもやめた方がよさそうです。

カリフォルニアで3人のアーティストがStable Diffusion、Midjourney に対して

「何百万人ものアーティストの権利を侵害する21世紀のコラージュツールであり、作品市場に実質的な悪影響を与えている。」

として訴訟を起こしているそうです。

裁判で著作権侵害を主張するには1対1で作品を比較して検証することが前提になっていて、現在の著作権法はAIによる著作権侵害に対処する能力を備えていないという意見があるようです。

現在のところ、AIを使って制作された作品には著作権は認められないとされています。

こういったAIプラットフォームを運用することの合法性についても疑問視されているそうです。

以下は記事からの抜粋です。

「現行の(米国の)著作権法は、誰が何を所有するかという概念を容易に決定できた時代に制定されました。

影響力とアウトプットがより曖昧なAIの時代に、創作と所有権の問題は複雑になっていて、この裁判を難しくしています。」

ある弁護士によると・・・

「1年前と比べると、巨大なテック企業が同意もクレジットも補償もなしに、人間が創作した作品にAIをトレーニングさせることには法的・倫理的問題があるという考えが、より広く受け入れられていると思います。・・・最終的には、生成AIは人間が作成したデータに依存するため、これらの企業はクリエイティブ産業と協力することを好むと思います。AI企業が人間のクリエイターを破産させれば、彼ら自身もすぐに破産するからです。」

また別の弁護士は・・・

「この集団訴訟の理論は、アーティストにとって非常に危険です。たとえ最終的な結果が実質的に類似していなくても、他人の芸術のいかなる側面でも自分の作品に取り入れ二次的著作物を創作したと裁判所を説得すれば、好きなアーティストの目の描き方をコピーするようなありふれたことでも、法的な危険にさらされる可能性がある。」

また、ゲッティイメージズも

「ゲッティイメージズの知的財産を驚異的な規模で堂々と侵害している 」

としてStability AI社を法廷に提訴しているそうです。

いつか、制作物はNFTになってることが必須になって、作者が実在の人間であることを証明することも必要になるのかも。

The future of art is in AI’s hands >>

Judge Appears Likely to Dismiss AI Class Action Lawsuit by Artists >>

これがいつかフランス革命の人権宣言のような歴史的なドキュメントになるのかも。

スーパーインテリジェンスは、これまでのどのテクノロジーも超える能力を持つと考えられています。

これには、原子力のIAEAのような規制や基準が必要になるとのことです。

ただし、スーパーインテリジェンスほどの重大な能力に至らないAIモデルの開発には、規制や基準を適用しないことも重要であるとも言っています。

これはスーパーインテリジェンスへの注目が薄れないようにするためだそうです。

「スーパーインテリジェンスの創造を止めることは危険であり、困難であると私たちは考えています。利点が非常に大きく、それを構築するコストは年々減少し、それを構築する主体の数は急速に増加しています。それは本質的に私たちが進んでいる技術的な道の一部であり、それを阻止するには世界的な監視体制のようなものが必要になるでしょう。それさえも動作する保証はありません。したがって、スーパーインテリジェンスを正しく理解する必要があります。」

ガバナンスの導入には公的機関が必要で、限界とデフォルトを民主的に決定すべきとしています。

その通りだと思います。

すごくSF的な話のようでもあるし、テクノロジーと人の関係のよくある話のようにも聞こえます。

デンマークのbe my eyes社は、GPT-4の画像認識能力を利用して「バーチャル・ボランティア」という、送られてきた画像に関する質問に答えるアプリだそうです。

これまでにも同様のアプリはあったようですが、

「ミスが多かったり、会話ができなかったりと、市販のツールでは、私たちのコミュニティが抱える多くのニーズを解決することはできませんでした。」とのことです。

新しい機能は人間のボランティアと同レベルの文脈と理解を提供できるそうで、視覚障害者のユーザーから好評のようです。

be my eyesではこれまで、人間のボランティアのみでユーザーをサポートしていました。

ユーザーが期待するような答えを得られなかったり、人間の対応の方が望ましい場合には、ボランティアに依頼することもできるそうです。

与えられた新しいオモチャで遊んでいるだけでなく、役に立てるニーズを見つけた方が良さそうです。

New GPT-4 app can be ‘life-changing’ for visually-impaired people, say users >>

© 2026 DESIGNERS UNION | ご自由に投稿できます。 お気軽にご利用ください。