「感情を持った」と言われたGoogleのAIがサイトで公開されるらしい

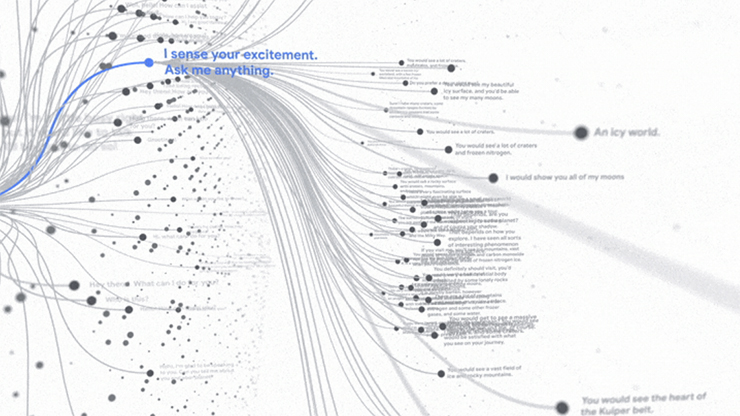

グーグルの対話特化型AI「LaMDA」が知性や感情を獲得したというエンジニアの主張がありました。

このエンジニアは解雇されてしまいましたが、Googleはこの「LaMDA」を「AI Test Kitchen」というサイトで公開する準備をしているそうです。

公開されるのは「LaMDA2」という改良版のようす。

LaMDA2を使用するのは登録制で、まずは少人数のグループから少しづつ始めていくようです。

Googleは、LaMDA2との会話を製品やサービスの改善に利用するとしていて、人間のレビュアーが利用者のチャットを「読み、注釈を付け、処理」することができるとしているそうです。

Googleはここでフィードバックを集めて、LaMDA2をサービスや製品に展開する準備を進めるようです。

まるでSFのようです。

リンク先の記事では、そこにどんな危惧があるのかを紹介しています。

以下は抜粋です。

「LaMDAは有害な出力や事実上不正確な情報を生成することができる。また、Googleのエンジニアの主張が示唆するように、人間であるかのような錯覚を起こさせる能力を身に付けている。もしLaMDAがGoogleアシスタントを動かすとしたら、どのような影響があるか想像してみてください。人々は、AIモデルの毒性や偏りの犠牲者となり、AIモデルの言うことを盲目的に信じ、Googleのエンジニアに起こったように、AIモデルに愛着を持つようになるかもしれないのです。」

「私たちは、大手ハイテク企業がこうした強力なAIモデルのコントロールを簡単に失ってしまうことを何度も見てきました(GoogleとMetaは、AIモデルの不品行について常に-後付けで-謝罪しています)。彼らでさえLLMの不祥事を正確に予測できないのであれば、素人がLLMと健全に付き合うには、どれほど準備不足なのだろうか。」

「LaMDAは非常に便利ですが、ユーザーの期待に応えられないこともあり、最悪の場合、何らかの形で危害を加えることもあることを彼らは知っています。だからこそ、彼らは改善のためのフィードバックを求めているのです。」

「研究開発から製品化への移行は些細なことではないので、慎重に行う必要があります。このようなAIモデルが世の中に出てくると、企業はそれに対するガバナンスを失います。しかし、安全性の欠如、そして起こりうる悪評さえも利益で補えるのであれば、企業はそれを実行するでしょう。・・・LaMDAが、Googleが設定した製品化のための閾値を超えるかどうかはともかく、LaMDaが、確かに、感覚を持たないことは、自分で評価できるかもしれない。」

難しくてよくわからないですが、世の中にリリースされたら大きな影響力を持つことになるのでしょう。

「皇帝の新しい心」とか読むと、もっとおもしろく理解できるのかな。

Google Is Making LaMDA Available >>

© 2025 DESIGNERS UNION | ご自由に投稿できます。 お気軽にご利用ください。

Leave a Comment